伴随着深度神经网络的发展、测算储存的扩张、数据可视化数据集的猛增,电子计算机视觉效果等方面的科学研究在最近几年迅猛发展。在无人驾驶汽车、保健医疗、零售、电力能源、应用语言学等众多行业,计算机视觉的应用都更加广。

我们将在这篇文章中详细介绍 2018 年核心了计算机视觉探索的 5 个必然趋势。详细回望很难,这里只能共享这一领域里令我印象深刻成就的。

1 — 合成数据

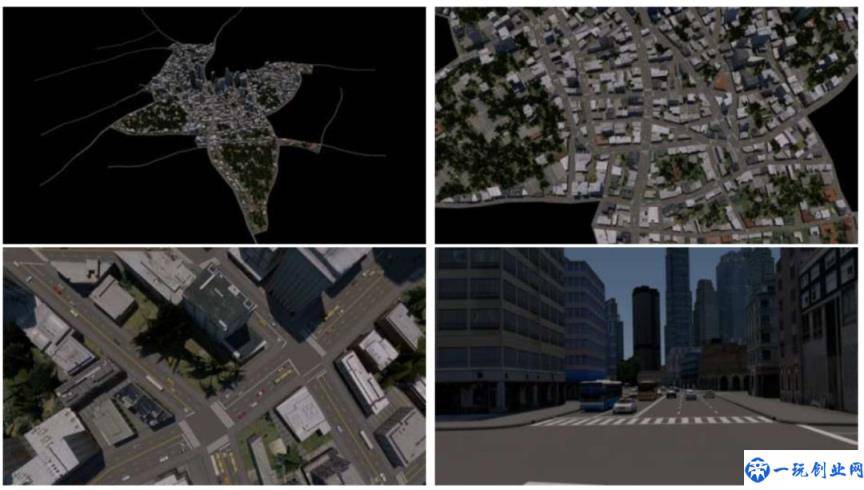

合成数据,即人力合成、用于练习深度学习模型的数据,在 2018 年计算机视觉研究方向无疑是重中之重。比如这一 SUNCG 数据集 被用来仿真模拟室内空气,这一 Cityscapes 数据集被用来安全驾驶和导航栏,这一合成人类 SURREAL 数据集 被用来学习培训姿态可能和跟踪。让我们一起来过一遍 2018 年运用合成数据的绝佳成效们:

- 在 How Well Should You Label (你应该标识的多好) 中, 创作者紧紧围绕为了能从当代 CNN 构架中获得优良的划分品质,对练习标签的质量标准多么低。 这很重要,由于合成数据一般因其清晰度完美品质而著称。 作者在 Auto City 数据集中进行试验,证实最后的划分品质的确与标识所花的时间量息息相关,但是和每一个标签的品质不相干。

- Soccer on Your Tabletop (桌面上足球队) 给出了一个可以拍照足球赛事的视频采集并把它转换成挪动 3D 复建的软件,该复建可以被投射到桌面并用增强现实技术系统进行收看。系统软件获取运动员边界框,采用姿态和深度估计模型分析角色图型,最后获得十分精准的3D情景复建。

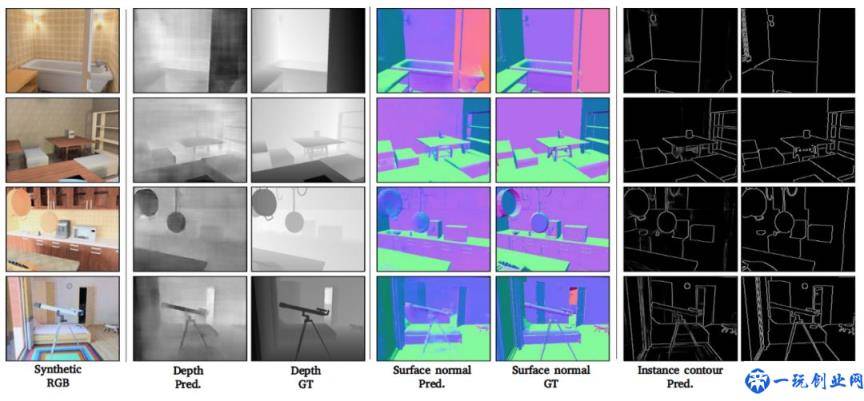

- 已有的大多数特征学习方法都欠缺人们那般与此同时从各个信息特征的学习能力。Cross-Domain Self-supervised Multi-task Feature Learning(跨学科自监督多个任务特征学习) 应用合成图象根据提出一个最原始的多个任务深度学习网络去解决这一差别,该互联网应用合成图象来能够更好地学习培训跨模态设置里视觉的表明。根据合成图象练习互联网大大减少了多任务学习所需要的通常价格昂贵且费时的数据注解。为了能消弭真正数据和合成数据间的跨域请求差别,在无监督的特点级域适应方式中选用竞技性学习培训,提升了在视觉效果特点专业知识到真实世界任务转移层面表现的。

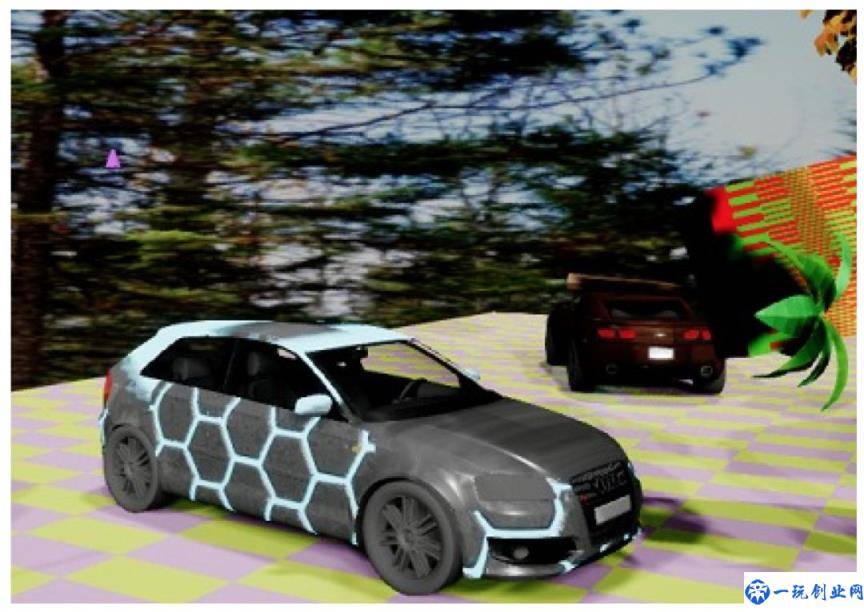

- Training Deep Networks with Synthetic Data (用合成数据练习深度网络) 给出了一种依靠合成数据的域动态随机练习用以真正物体检测的神经网络算法数据的精准方式。域动态随机根据有意和任意地影响环境中的纹路来驱使互联网对焦并鉴别对象主要特点,从而降低对高品质仿真模拟数据集的需要。为了能提高这一全过程性能,将进行融合合成数据和真正数据的另外练习,进而消弭实际差别、获得更好的特性。毕业论文还给出了不一样的方法去充分发挥合成数据的发展潜力,觉得这一行业同样会在两年进一步发展。

2 — 视觉效果互动问答

视觉效果互动问答(Visual question answering,VQA)是一种融合计算机视觉和自然语言理解的新情况。一般牵涉到给电子计算机展现一张图片,让电子计算机回应有关图形的难题。回答能是下列任何一种方式:一个单词,一个短语,是/否,选择题答案,或者填空回答。

例如 DAQUAR, Visual7W, COCO-QA, VQA 什么的多种多样数据集都专注于处理此项每日任务. 使我们一样一起来看看视觉效果互动问答领域内的在今年的最好:

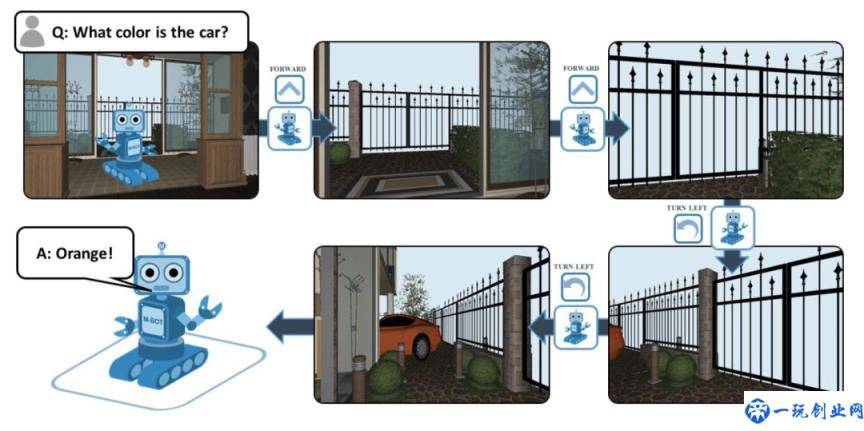

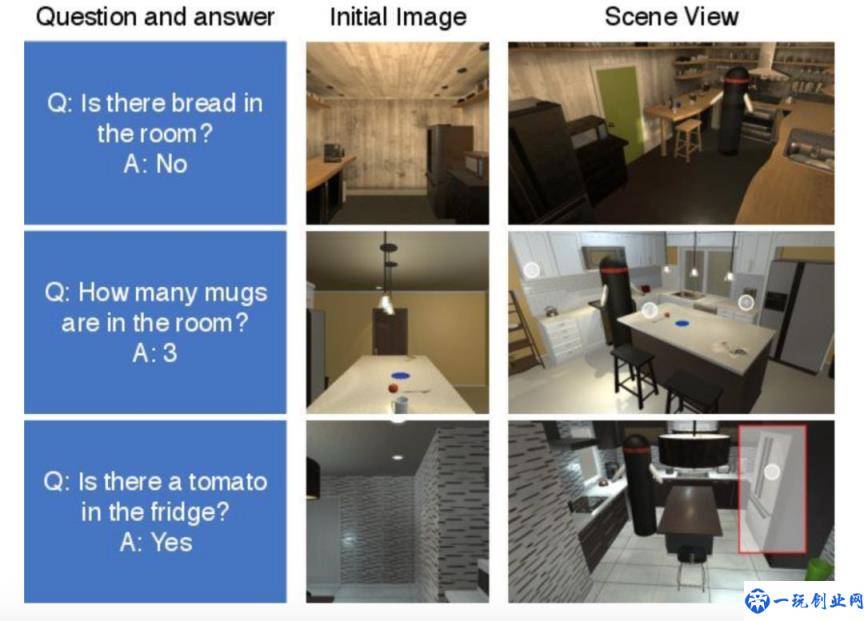

- Embodied QA 以建立彻底智能化代理为主要目标,这种代理能够主动地认知,在根据环境中的谈话中当然沟通交流、状态和运行命令。根据目标驱动的 3D 设定行车导航,代理被要求根据对象识别和视觉定位与理解来解答问题。有意思的是,该代理仅应用以自我为中心视觉效果来导航栏其周边环境。这就意味着代理并没有给予地形图,只能依靠初始感观键入(清晰度和英语单词)进行练习,而且需要借助知识来导航栏不熟悉的地方。

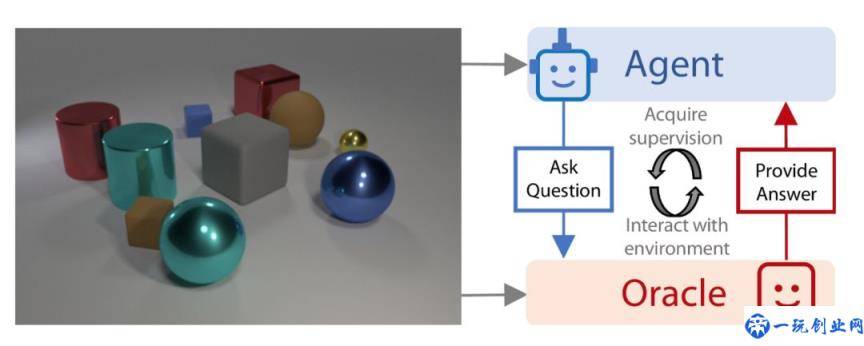

- 标准化的 VAQ 实体模型比不上人们当然互动交流那般取样高效率、简略,只是处于被动地取决于大中型静态数据数据集。Learning by asking questions 根据引进效仿当然学习更具有交互性的 VQA 实体模型弥补了这一科学研究空缺。在本文中,根据评定其此前得到的基础知识并了解有关的好问题来更大化来源于发送至 oracle 的每一个图象-难题对于学习数据信号,练习代理像人一样学习培训。该毕业论文还展现了互动式提出问题怎样明显降低多余和训练所需样版,并实现准确度提升40%。

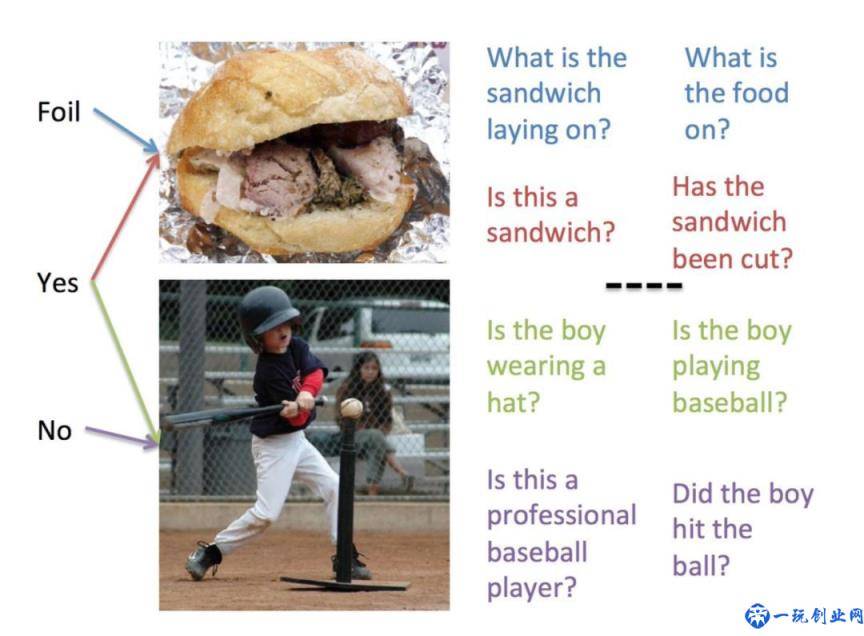

- Inverse Visual QA (iVQA) 连接着别的希望通过致力于开发设计视觉定位来提高标准 VQA 实体模型的性能实体模型。文中颠倒了最流行的 VQA 每日任务,目的在于在给出图象/回答对的情形下形成难题。规范 VQA 课程的学习误差破坏评定全过程。iVQA 应用一部分产生的难题,相匹配于图象-回答正确的误差比较小的学习培训先验,并实现更多视觉定位。

- Interactive QA 专注于处理规范 VAQ 模型的一个薄弱点:一般是被动接受,不可以练习可以在其环境里导航栏、互动与执行任务彻底智能化的代理。该模式应用具备语义空间的记忆多级别控制板方式,搜集仿真模拟真正场景下的丰富多彩数据集和广泛难题以评估模型。它促进规范 VQA 向着建立彻底视觉智能代理的终极目标迈入。

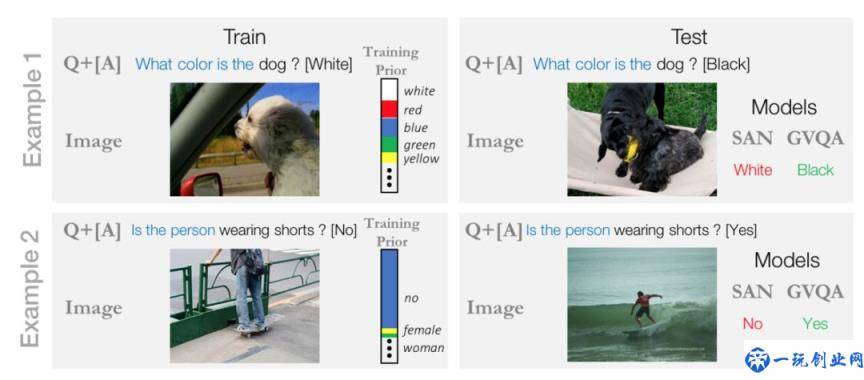

- 高效地评定现阶段最先进 VQA 模型的特性并避免他们依靠有偏差练习先验是一个依然在设计中的行业。为了能这一总体目标,Grounded Visual QA 实体模型提供了一种新的方法,能直接分离出来从科学合理的此前回答中辨别出对象,进而驱使实体模型更多的去视觉定位。从本的报告出色成效及现阶段小区对这一研究方向的高度关注看来,将来用创新思维方法进一步推进 VQA 实体模型很还有希望。

3 — 域适应

2018年有一些特定研究内容,一个是域适应。这一领域事实上与合成数据息息相关。它处理了为无监督学习搜集标识数据集以确保数据充足靠谱和多元化这一极大考验。 这一问题的核心是,我们怎样应用一种数据让互联网能解决不同类型的数据。

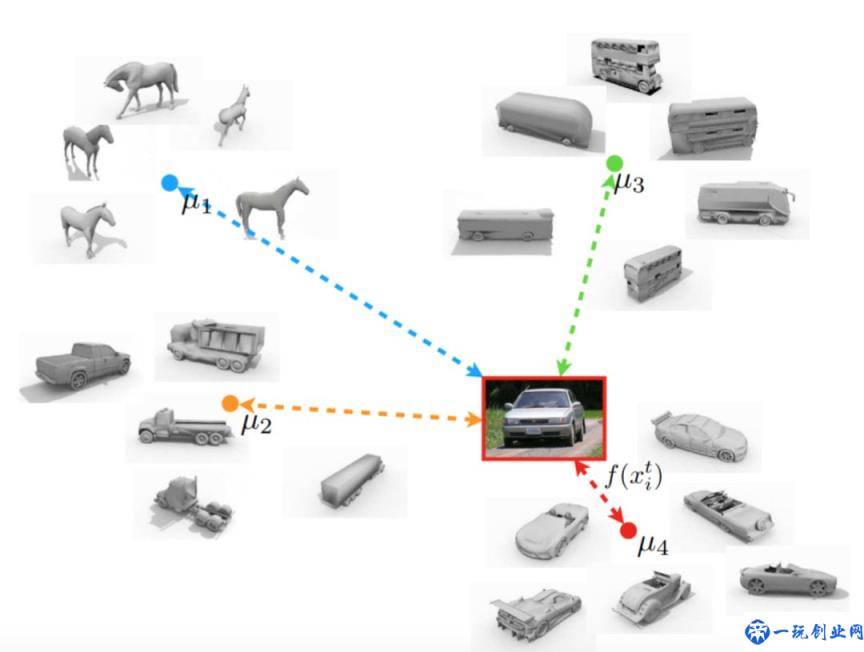

- Unsupervised Domain Adaptation with Similarity Learning(用相似性学习培训完成无监督域适应 应用竞技性互联网解决域适应。创作者让一个互联网从标注的源域和另一个网络里提取特征,并实现从一个未标识的目标域中获取具备类似而不同数据遍布的特点。训练模型以将总体目标原形与任何别的原形区别开来的种类是不一样的。为了能标识来源于目标域的图象,创作者将图象的置入与来源于源域原型图象的置入进行对比,随后分派其最相邻标识。

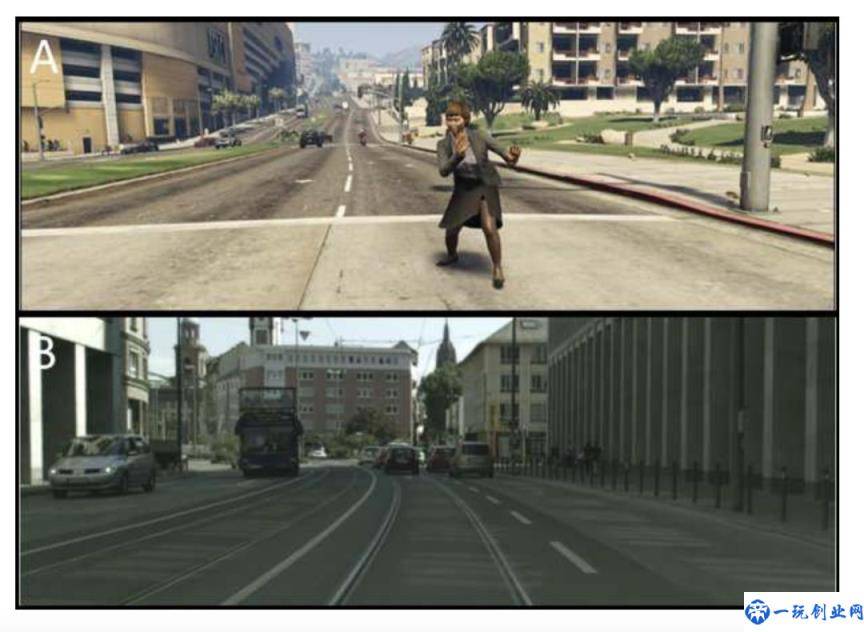

- Image to Image Translation for Domain Adaptation (域适应的图象到图像转换 科学研究用以边缘检测的域适应,其广泛运用于无人驾驶汽车,医学成像和大多数别的行业。从源头上而言,这一域自适应技术性务必寻找从源数据遍布到总体目标数据分布投射构造。此方法应用3种关键技术性:(i)domain-agnostic feature extraction(从源域和目标域提取特点的遍布没法区别),(ii)domain-specific reconstruction(置入能够被编解码回源域和目标域 ),和(iii)cycle consistency(恰当学习培训投射)。

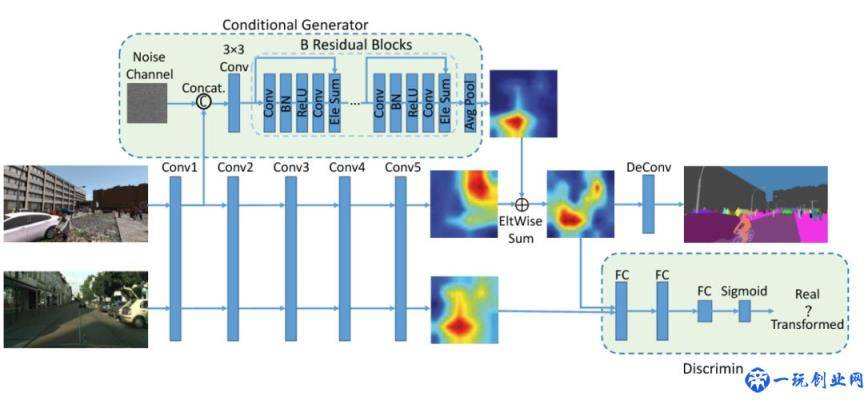

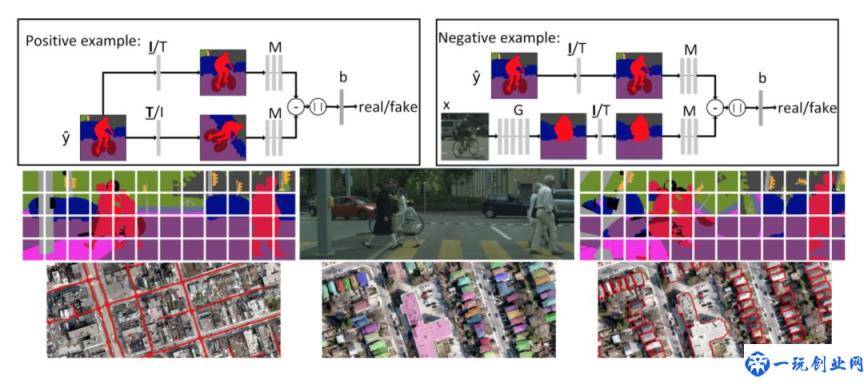

- Conditional GAN for Structured Domain Adaptation (用以结构型域适应的前提条件 GAN 提供了一种新的方法,根据结构型域自适应方式摆脱语义分割实体模型中跨域差别的考验。与无监督域自适应不一样,此方法不假定存有跨域公共性特征空间,反而是选用标准制作器和鉴别器。因而,标准 GAN 被集成化到 CNN 架构中,转移标识的合成图像域到未标记真实的图象域。此方法得到的结果好于之前的实体模型,体现出了生成数据在推动视觉效果每日任务层面日益增长的发展潜力。

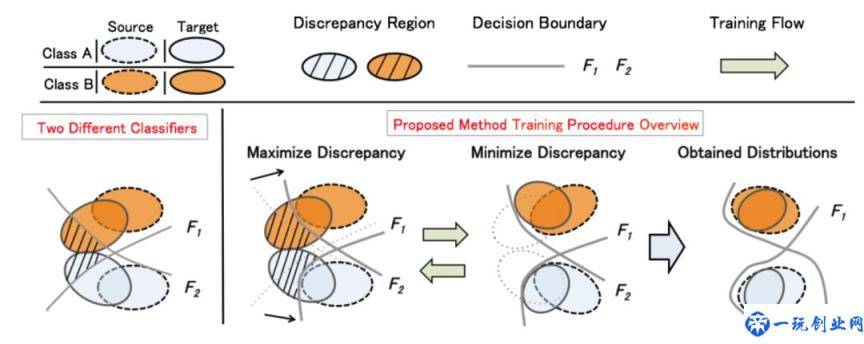

- 练习基于深度学习的实体模型依靠很多带批注的数据需要很多网络资源。虽然在很多视觉识别系统任务时完成了最先进特性,但跨域差别仍是一个极大的考验。为了能跨域转移专业知识, Maximum Classifier Discrepancy for Unsupervised Domain Adaptation 应用有创意的竞技性学习的方法开展域适应,而无需来源于目标域的所有标识信息内容。据观查,此方法降到最低来源于目标域的样版的两大分类算法的几率可能之间的差别,能够造成用以从种类到语义分割的各类任务类辨别特点。

4 — 生成对抗网络

2018 年针对计算机视觉最出色的生成模型 – 生成对抗网络(GAN)而言毫无疑问是不可或缺的一年。 下面我们就来赏析一些改善 GAN 模型的本年度最佳著作:

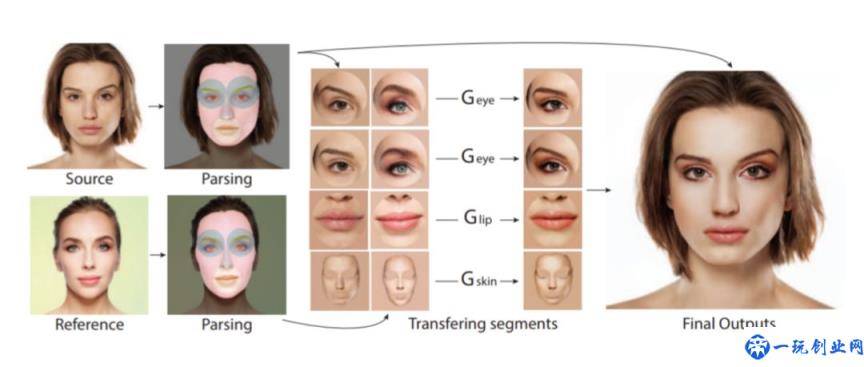

- 标准 GANs 早已广泛运用于图象模型,但是它们针对风格迁移也非常有利。特别是他们可以学与特殊图象原素相对应明显特点,随后更改他们。在PairedCycleGAN for Makeup中,创作者们给出了一个图片妆面整修的架构。他们为不同类型的脸部部件练习各自制作器并独立运用他们,采用不同的互联网获取脸部因素。

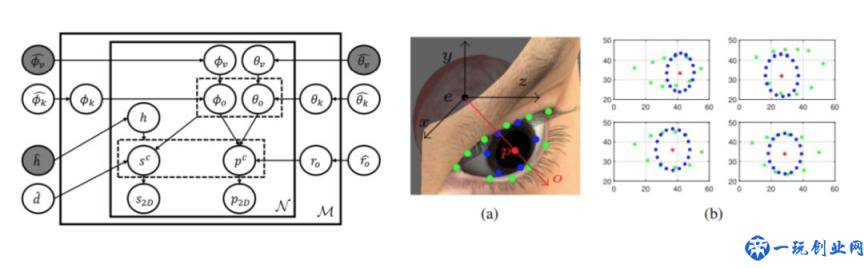

- Eye Image Synthesis with Generative Models(生成模型的双眼图像合成) 紧紧围绕形成人的眼睛图象问题。这是一个有意思的测试用例,只要我们可以用产生的双眼去解决视野可能难题——一个人在看啥?创作者应用眼型生成的概率模型和 GAN 构架来形成遵照该模型的双眼。

- Generative Image In-painting with Contextual Attention(根据具体内容认知生成模型的图像修复) 论述了弥补图象空缺这一趣味性难题。一般,要修补图象,我们应该掌握基本情景。而此方法应用 GAN 实体模型,应用周边图像中的特点来明显改进形成。

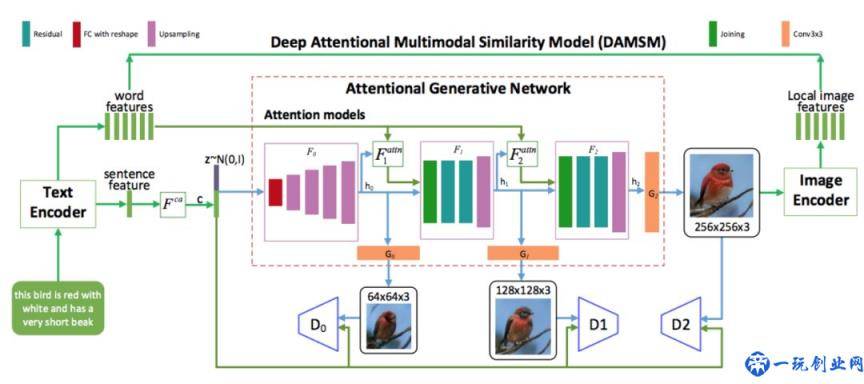

- 现阶段最先进根据 GAN 的文字到图像生成实体模型仅仅在语句等级编号文字叙述,并忽视可以改善形成图像分辨率的英语单词级别粗粒度信息内容。AttnGAN 给出了一种有创意的词级注意力机制,在设计繁杂情景时作用更赞。

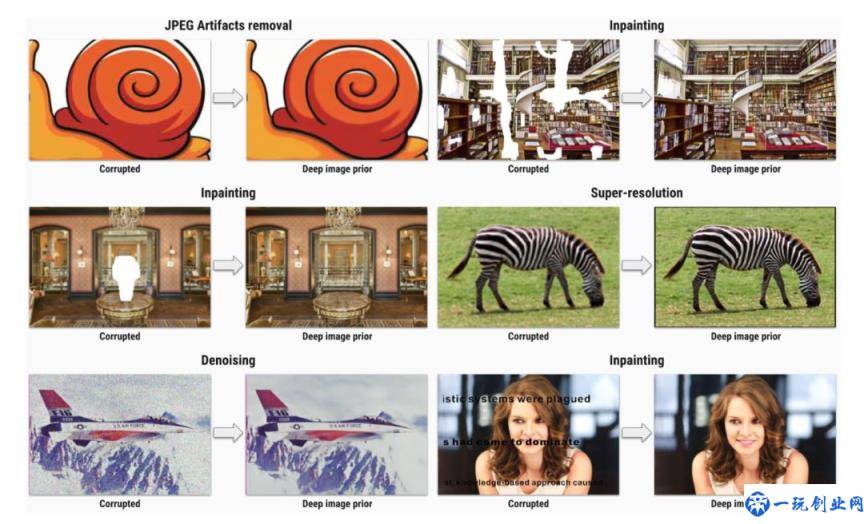

- 和广泛的观点不一样的是,神经元网络成功的主要来源于于她们从数据中成长强大的水平,Deep Image Prior(深度图像先验) 展现了网络架构针对树立良好的图象先验的必要性。文中给出了一种做为显像每日任务先验的编解码互联网。有意思的是,创作者展现了在所有的学习培训以前,制作器互联网就足够捕捉大量低等图象数据统计。创作者还应用此方法根据造成所谓当然预图象(natural pre-images)来探讨保存在互联网的差异等级的信息。一样有趣的是,应用深度图像先验做为正则项,从十分深等级所获得的预图像中依然能获得很多数据。

- 虽然 GANs 很出色,但是其鉴别器互联网做为一般监管每日任务(如语义分割)的通用性交叉熵其实不算很出色。Matching Adversarial Networks(配对对抗网络) 阐述了深层原因,即交叉熵没有直接依靠制作器练习阶段的真实值(ground truth)标识,这就导致从样本分布中任意造成样版且不以监督方式关系键入-导出关联。因为摆脱这种情况,文中明确提出用匹配网络更换鉴别器,与此同时考虑到真实值导出及其产生的实例——由孪生网络构架促使。

5 — 3D 目标了解

3D 目标了解针对深度学习系统取得成功解释和引导真实世界尤为重要。 比如,互联网或许可以在街道社区图像中精准定位车辆,向其全部清晰度上色,并把它归为车辆。 但难点在于它是不是真的可以了解图像中的车相较于街道社区中的许多一个物体部位。

3D 目标了解涉及到广泛研究方向,包含对象检测,目标追踪,姿态估计,深度估计,情景复建等。 一起来看看 2018 年这一领域的重要毕业论文:

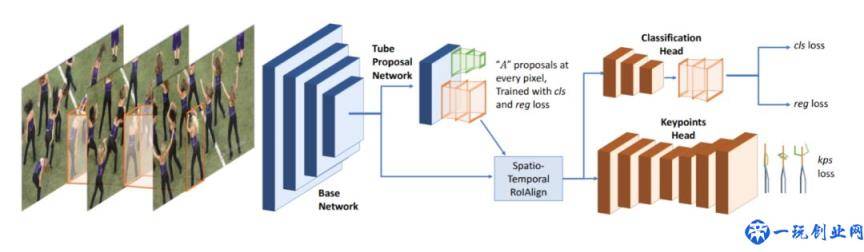

- Detect-and-Track 是 2017 年发生的最有前景的边缘检测方法之一 Mask R-CNN 的拓宽。创作者给出了一种 3D Mask R-CNN 构架,它应用时光卷积和来提取特征并立即鉴别短视频中姿势。完备的构架具体如下。他在姿态可能与人体跟踪层面完成了现阶段最佳结论。

- Pose-Sensitive Embeddings for Person Re-Identification 解决了行人重识别(person re-identification)的考验。一般,这种情况根据基于查找的方法去处理,即求导数查看图象与来源于某一置入区域的储存图象间的相似性衡量。这篇论文明确提出将姿态信息内容立即置入到 CNN 中,并设计了一个无监督的重排序新的方法。构架如图所示。

- 3D Poses from a Single Image(根据纯色图象的 3D 姿态 ) 给出了一种姿态可能的特殊方式。它先通过一种融合了姿态可能、身体轮廊切分和网格生成的端对端卷积和构造形成人体 3D 网格图,关键环节取决于它用了 SMPL,一种应用统计学人体样子实体模型,为人体的形态带来了较好的先验。因而,它能够从一张纯色图象结构人体 3D 网格图。

- Flow Track (光流有关过滤) 则专注于目标跟踪难题。这是有关过滤类方式(DCF,discriminative correlation filter)的拓展,学习和目标相对应过滤并把它用于全部视频帧。其实体模型系统架构具备室内空间-时长专注力(spatial-temporal attention)体制,关心视频里的不同时期帧。(译者注:在 spatial attention 中,用余弦距离考量,对空间坐标上每一个待结合的点分派权重:和现阶段帧越类似,权重越多,相反越低;这样做的关键是现阶段帧的权重始终是极大的,因此创作者参考 SENet 的观念制定了时长权重 temporal attention,是指将每一帧看作一个channel,设计一个品质分辨互联网,互联网导出的结果就是每一帧的品质打分。temporal attention 和 spatial attention 融合,完成 feature map 的结合。)

- 与上述 Flow Track 同样,Correlation Tracking 是用有关滤波处理目标跟踪。但是此方法不能使用神经网络算法,反过来,它包括稳定性信息 – 这就意味着作者在目标函数中加入了一项,用以仿真模拟学习培训过滤器稳定性。

希望你会喜欢这篇文章微评。 假如你有兴趣爱好探寻大量,提议阅读文章CVPR,ICLR, 及其机器学习算法和人工智能领域最著名的大会——NeurIPS。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 举报,一经查实,本站将立刻删除。